Объединение сетевых карт ESXi 5.5 для балансировки нагрузки с использованием Cisco Etherchannel

Я использую стековый коммутатор Cisco 3750G, настроенный с etherchannel и подключенный к ESXi Server, настроенному с объединением сетевых карт; Балансировка нагрузки в качестве маршрутизатора на основе IP Hash. Конфигурация коммутатора Cisco: ( VID 199 - ESXi-Mgmt)

interface Port-channel4

description "ESXi Mgmt"

Switchport turnk encapsulation dot1q

switchport trunk native vlan 4094

switchport trunk allowed vlan 199,200

switchport mode trunk

spanning-tree portfast trunk

!

interface GigabitEthernet2/0/2

Switchport turnk encapsulation dot1q

switchport trunk native vlan 4094

switchport trunk allowed vlan 199,200

switchport mode trunk

channel-group 4 mode on

!

interface GigabitEthernet3/0/2

Switchport turnk encapsulation dot1q

switchport trunk native vlan 4094

switchport trunk allowed vlan 199,200

switchport mode trunk

channel-group 4 mode on

Конфигурация хоста ESXi:

Создана новая группа портов vmkernel под названием ESXi-Mgmt и добавлены NIC0 и NIC4(дополнительная плата NIC)

настроил vswitch и portgroup с объединением сетевых карт как | Балансировка нагрузки: Маршрут на основе IP Hash | Обнаружение отказоустойчивости сети: только статус ссылки | Уведомить swtiches: Да | Запасной вариант: да

настроил IP для группы портов как 10.1.199.9

~ # esxcfg-vswitch -l

Switch Name Num Ports Used Ports Configured Ports MTU Uplinks

vSwitch0 3322 4 128 1500 vmnic1

PortGroup Name VLAN ID Used Ports Uplinks

VM Network 0 0 vmnic1

ESXi Management 0 1 vmnic1

Switch Name Num Ports Used Ports Configured Ports MTU Uplinks

vSwitch1 3322 6 128 1500 vmnic0,vmnic4

PortGroup Name VLAN ID Used Ports Uplinks

ESXi-Mgmt 199 1 vmnic0,vmnic4

ПРИМЕЧАНИЕ: у меня также есть NIC1, подключенный (другая подсеть), чтобы я мог получить доступ, используя свой ноутбук, находящийся в той же сети. (настройка во время установки ESXi)

У меня есть сервер, связанный с портом коммутатора Cisco, настроенным как порт коммутатора доступа для VLAN 199.

ПРОБЛЕМА: Я могу пропинговать IP 10.1.199.9 с сервера, упомянутого выше, но не могу получить к нему доступ через веб-клиент vsphere.

Кто-нибудь, пожалуйста, помогите мне решить проблему, так как мне пока не повезло найти какое-либо решение? Настройка кажется правильной при просмотре направляющих.

4 ответа

Мне удается решить проблему. Я в основном настроил ESXi с настройками etherchannel и VID в соответствии с рекомендациями Vmware. Как только etherchannel установлен, соединение с хостом esxi было разорвано, что означает, что etherchannel настроен правильно. затем я настроил порты коммутатора Cisco, чтобы они находились в etherchannel с правильным VID. Это работало как кусок пирога.

Ответ о том, что LACP не поддерживается стандартным vSwitch, является правильным. Etherchannel поддерживается vSwitch, хотя. Так что вы, наверное, задаетесь вопросом, что не так с etherchannel?

При совместной работе с etherchannel один сеанс TCP/UDP не будет использовать совокупную пропускную способность всех каналов вашего канала. Это будет ограничено одной ссылкой. Таким образом, если у вас есть 2 x 1 ГБ ссылки в вашем etherchannel, любая сессия никогда не будет превышать 1 ГБ. Другие сеансы TCP/UDP будут сбалансированы по всем каналам, что поможет предотвратить насыщение, но с одним сеансом TCP/UDP никогда не будет достигнута истинная суммарная пропускная способность.

Etherchannel все еще имеет применение, хотя. Это помогает предотвратить насыщение канала, когда несколько каналов сбалансированы по каналу. Это также полезно для создания отказоустойчивых соединений из стека коммутаторов, где вы берете порты от отдельных коммутаторов, которые участвуют в стеке или объединительной плате шасси, и помещаете их в межканальный сетевой канал, чтобы сбой одного коммутатора не устранялся Ваш хост ESX.

Резервные NIC, назначенные vSwitch, обеспечивают отказоустойчивость, но при этом происходит некоторое прерывание из-за того, что esx заполняет таблицы CAM вышестоящего коммутатора MAC-адресами. Etherchannel на шаг выше аварийного переключения ESX NIC.

Выключите Etherchannel. Вы действительно не можете использовать его в описанной вами ситуации. Если вы используете стандартный vSwitch, вы можете установить политики балансировки нагрузки и использовать несколько сетевых адаптеров, используя хэш IP, но это действительно делается на стороне ESXi. LACP/Etherchannel не вступает в игру, если вы не используете распределенный коммутатор (dvSwitch или vDS).

Существует возможность создания статической агрегации без распределенного коммутатора, но она не дает никаких преимуществ по сравнению с балансировкой нагрузки ESXi по умолчанию. Это не распространено.

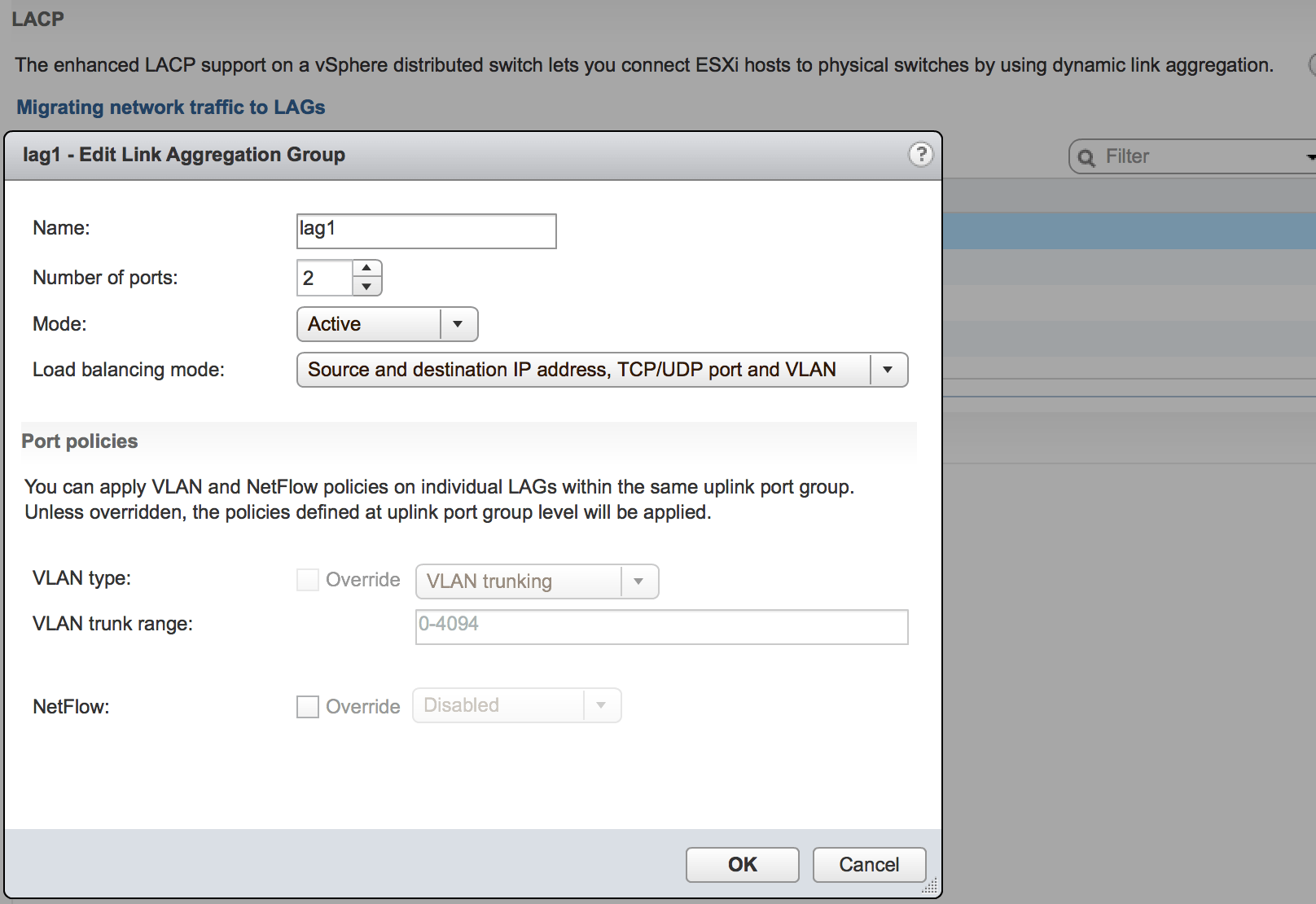

Если у вас нет чего-то похожего на это, где вы определили " Группу агрегации ссылок ", вы можете пойти по неверному пути.

Используете ли вы vDistributed Switch (vDS) или обычный vSwitch? LACP полностью работает только с vDS, и для этой функции требуется лицензия Enterprise Plus.