Комбинация ZFS и Hardware для получения Raid 51

Я ищу решения RAID для очень большого файлового сервера (70+ ТБ, ТОЛЬКО обслуживающий NFS и CIFS). Я знаю, что использование ZFS raid поверх аппаратного рейда, как правило, противопоказано, однако я нахожусь в необычной ситуации.

Мое личное предпочтение было бы настроить большой RAID-51 виртуальные диски. Т.е. два зеркальных RAID5, каждый из которых имеет 9 данных + 1 горячую область (поэтому мы не теряем слишком много места для хранения). Это облегчает мою административную паранойю, поскольку данные зеркально отражаются на двух разных дисковых шасси, и в то же время допускается 1 сбой диска в каждом наборе зеркал до наступления кризиса.

ОДНАКО этот вопрос проистекает из того факта, что у нас есть существующие аппаратные RAID-контроллеры (интегрированное дисковое шасси LSI Megaraid + сервер), лицензированные ТОЛЬКО для RAID5 и 6. У нас также есть существующая файловая система ZFS, которая предназначена (но еще не настроена) обеспечить ГА с использованием РФС-1.

Из того, что я вижу в документации, ZFS не предоставляет решение RAID-51.

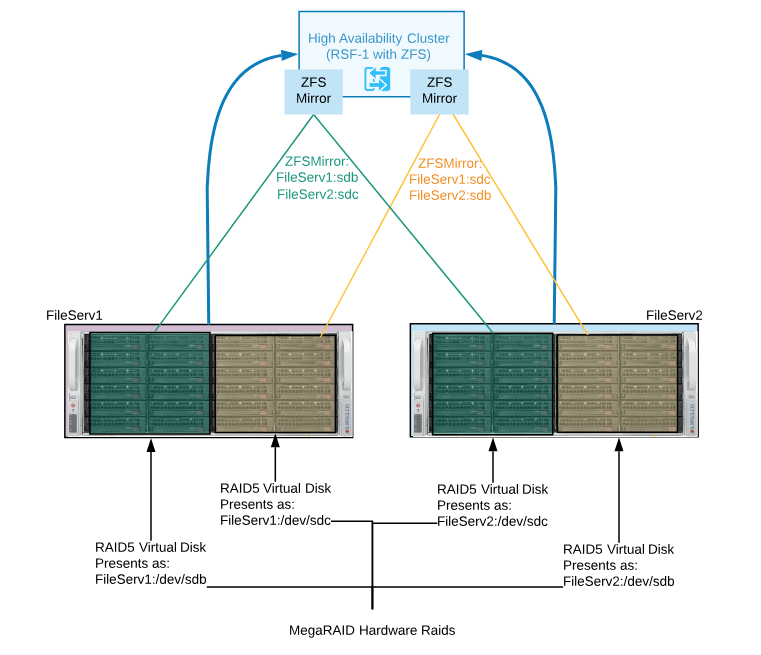

Рекомендуется использовать аппаратный рейд для создания двух виртуальных дисков RAID5 одинакового размера на каждом шасси. Эти два виртуальных диска RAID5 затем представляются на соответствующие серверы как /dev/sdx.

Затем используйте ZFS + RFS-1 для зеркалирования этих двух виртуальных дисков в качестве набора зеркал HA (см. Изображение)

Это хорошая идея, плохая идея или просто уродливая (но полезная) конфигурация.

Есть ли лучшие решения?

1 ответ

Интересный вопрос...

Я удивлен использованием RSF-1. Вы видели мое руководство по ZFS для Linux High Availability?

Можно спроектировать то, что вы описали выше, однако это может быть слишком сложно.

Отдельно, ни один из этих вопросов не является:

Использование ZFS в условиях высокой доступности, безусловно, является нормальным запросом.

И использование ZFS на аппаратном RAID нормально.

Проблема с вашим дизайном заключается в том, что вы вносите в решение более сложную задачу, снижение производительности и больше точек сбоя.

Рабочие нагрузки CIFS и NFS могут извлечь выгоду из кэширования ZFS, что также должно учитывать топологию.

Если вы застряли с аппаратным обеспечением и не можете планировать решение с общим шасси с многопутевыми дисками SAS, лучше создать два домена сбоев и создать решение без совместного использования или пересмотреть требования и определить приемлемые потери. Например, от каких сбоев и ситуаций вы защищаете?

Если бы у меня было оборудование, которое вы описали выше, я бы построил два сервера хранения как отдельные узлы; обозначьте один как основной, другой как вторичный, и используйте форму непрерывной асинхронной репликации ZFS с первичной на вторичную. Это можно сделать безопасно с интервалом в 15 секунд, даже в загруженных системах.

Если вы хотите использовать оба сервера одновременно, вы можете обслуживать разные наборы данных на каждом и дублировать их в обоих направлениях. Если вам нужно использовать аппаратный RAID на каждом узле, это нормально. Вы по-прежнему сможете использовать кеширование ZFS RAM, управление томами, сжатие и, возможно, устройства L2ARC и SLOG.

Конструкция более проста, производительность будет максимально увеличена, что открывает возможность использовать более быстрые кеширующие диски и устраняет необходимость в дисках пула данных SAS. Вы также можете добавить географическое разделение между узлами или ввести третий узел, если это необходимо.